Comprendre l’indexation d’un site chez Google

Avez-vous déjà publié du contenu de qualité sur votre site, mais peine à le trouver sur Google ? Causé par une mauvaise indexation d'un site web, ce problème est plus fréquent qu'on ne le pense. Pourtant, il suffit souvent de quelques réglages pour débloquer la situation.

Être correctement indexé par Google est en effet indispensable pour exister sur le moteur de recherche leader. Sans indexation, impossible d’apparaître dans les résultats de recherche, même pour vos meilleurs mots-clés. Autant dire que votre visibilité est réduite à néant…

Heureusement, en suivant les bonnes pratiques, vous pouvez optimiser et accélérer l’indexation de votre site web par Google. En appliquant ces recommandations, vous maximiserez l’indexation de votre site et boosterez significativement votre visibilité sur Google. Suivez le guide !

Table des matières

Qu'est-ce que l'indexation d'un site web ?

L'indexation d'un site web est le processus par lequel les moteurs de recherche, tels que Google, analysent et enregistrent les pages d'un site web dans leur base de données, également appelée index. Lorsqu'un moteur de recherche indexe un site web, il explore et analyse le contenu de chaque page, y compris les textes, les images, les balises méta et autres éléments. L'indexation permet aux moteurs de recherche de comprendre le contenu d'un site web et de le référencer dans leurs résultats de recherche. Cela signifie que lorsque les utilisateurs effectuent des recherches sur des sujets pertinents, les pages indexées qui correspondent le mieux à leur requête peuvent apparaître dans les résultats de recherche.

L'indexation est une étape cruciale pour assurer la visibilité d'un site web dans les moteurs de recherche. Sans une indexation adéquate, un site web ne sera pas répertorié et ne pourra pas être trouvé par les utilisateurs lorsqu'ils effectuent des recherches.

Il est important de noter que l'indexation n'est pas garantie pour tous les sites web. Certains facteurs tels que la qualité du contenu, l'optimisation technique, les liens entrants et autres critères de pertinence peuvent influencer la façon dont un moteur de recherche indexe un site web. Par conséquent, il est essentiel de mettre en place une stratégie de référencement solide pour maximiser les chances d'une indexation efficace et d'une meilleure visibilité en ligne.

Comment fonctionne le processus d'indexation par Google

L'indexation suit un processus en 4 étapes orchestré par Googlebot :

🎯 Découverte des nouvelles pages

La découverte des nouvelles pages d'un site web consiste à mettre en place des techniques pour donner de la visibilité à du contenu inédit et inciter les internautes à le consulter. L'objectif est de donner une exposition maximale aux nouveaux contenus pour qu'ils soient rapidement découverts par les visiteurs déjà présents sur le site et aussi pour attirer de nouveaux lecteurs grâce à ces pages de qualité.

C'est un enjeu important pour tout site qui cherche à garder son audience engagée en publiant régulièrement des nouveautés et en mettant en place une stratégie efficace pour les faire découvrir. Googlebot découvre les URLs à crawler de différentes façons :

- Backlinks entrants pointant vers des pages du site

- Déclaration dans Google Search Console

- Liens dans des pages déjà indexées

- Sitemap XML

🎯 Crawling du site web

Le crawling désigne le processus par lequel les moteurs de recherche explorent et analysent les pages d'un site web pour les référencer. Des robots crawlers parcourent et indexent automatiquement les contenus. La fréquence de crawling dépend de plusieurs facteurs : popularité du site, mises à jour fréquentes ou non, temps nécessaire pour crawler l'intégralité des pages... Les sites importants sont crawlés en continu.

Googlebot visite et parcourt toutes les pages en analysant leur contenu texte et leurs liens sortants. Des outils comme Google Search Console permettent de suivre le crawling : nombre de pages indexées, statut HTTP des URLs, erreurs éventuelles... Ils fournissent des informations précieuses pour détecter et résoudre les problèmes.

🎯 Indexation des pages

Optimiser la balise title avec les principaux mots-clés et éviter qu'elle soit trop longue. Rédiger une meta description attrayante, concise et incluant des mots-clés secondaires. Alléger le poids des pages, minimiser les requêtes, améliorer le serveur. Rendre le site mobile-friendly pour une consultation confortable sur mobile.

Mailler les contenus entre eux avec des liens textes pertinents. Équilibrer les liens sur chaque page. Construire un réseau de backlinks depuis des sites partenaires de confiance. Viser la diversité des sources et éviter l'achat de liens. Suivre ses positions moteurs, trafic, taux de rebond. Analyser la concurrence. Fixer des objectifs et KPIs mensuels.

Après le crawling, Googlebot ajoute les pages du site dans son énorme index de plusieurs centaines de milliards de pages web. Googlebot revient crawler le site pour détecter les nouveautés, mettre à jour l'index et déréférencer les vieilles pages. L'indexation est donc un processus permanent géré automatiquement par les robots de Google.

Quels facteurs influencent l'indexation d'un site web ?

De nombreux éléments techniques et qualitatifs affectent l'indexation par Googlebot :

🎯 Budget de crawling

Le budget de crawling désigne le nombre de pages qu'un moteur de recherche comme Google peut explorer et indexer sur un site web durant une période donnée. Ce budget est limité. Plusieurs facteurs influencent le budget de crawling alloué à un site : sa popularité, le nombre de mises à jour, la taille du site, l'intérêt de son contenu pour les internautes. Des outils comme Google Search Console permettent d'avoir une estimation du budget de crawling de son site par Google et de voir les pages les plus crawlées. Pour améliorer son budget crawling et être mieux indexé, il faut gagner en popularité, améliorer sa structure interne, proposer du contenu engageant fréquemment mis à jour.

Les pages dupliquées, peu qualitatives ou apportant peu de valeur ajoutée sont moins prioritaires dans le budget de crawling de Google. Googlebot a une capacité de crawl limitée. Un site trop lent ne sera que partiellement indexé.

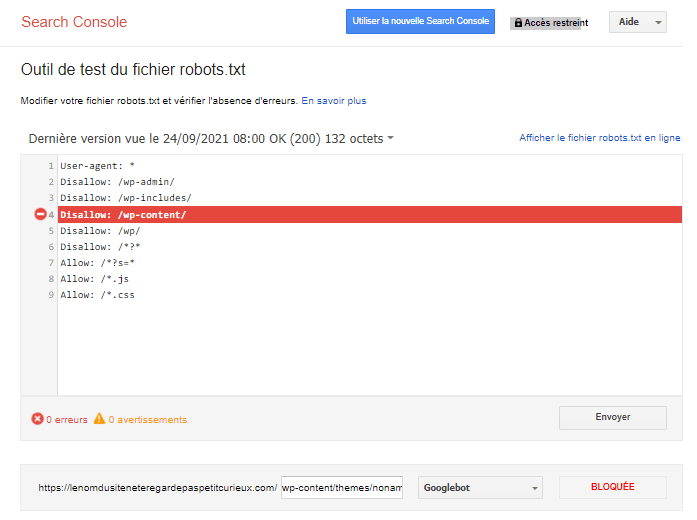

🎯 Fichier robots.txt

Le fichier robots.txt est un fichier texte utilisé pour indiquer aux robots d'exploration des moteurs de recherche les pages qu'ils sont autorisés à explorer sur un site web. Il est situé à la racine du site web et peut contenir des instructions pour différents robots d'exploration. Le fichier robots.txt est utilisé pour bloquer l'accès aux pages que vous ne souhaitez pas voir indexées par les moteurs de recherche. Cela peut inclure des pages de test, des pages de connexion, des pages de panier d'achat ou d'autres pages qui ne sont pas destinées à être indexées.

Le fichier robots.txt peut également être utilisé pour limiter la fréquence à laquelle les robots d'exploration accèdent à votre site web. Cela peut aider à réduire la charge sur votre serveur et à éviter les problèmes de bande passante. Il est important de noter que le fichier robots.txt ne garantit pas que les pages bloquées ne seront pas indexées par les moteurs de recherche. Les robots d'exploration peuvent ignorer les instructions contenues dans le fichier robots.txt ou indexer des pages qui ne sont pas incluses dans le fichier.

Il est également important de s'assurer que le fichier robots.txt est correctement configuré. Une mauvaise configuration peut entraîner des problèmes d'indexation, tels que l'indexation de pages importantes ou l'exclusion de pages importantes.

🎯 Vitesse et qualité technique du site

Un site rapide, en HTTPS, sans erreurs 404 sera mieux indexé. Commencer par identifier les URLs retournant ces erreurs 404 dans les outils d'analytics et de suivi comme Google Search Console. Cela permet de voir les pages manquantes.

Rediriger quand possible. Si l'URL n'existe plus, mettre en place une redirection 301 vers une page similaire encore en ligne quand c'est possible. Cela conserve le capital SEO.

Supprimer les liens morts. Supprimer tous les liens internes pointant vers des URLs en 404. Ces liens cassés nuisent à l'expérience utilisateur.

Ne pas laisser d'URL orpheline. Toute URL doit mener soit à une page active, soit à une redirection. Il ne faut pas laisser d'URL permanente en 404 sans solution.

Créer une page 404 personnalisée. Mettre en place une page 404 attractive expliquant à l'utilisateur que la page est introuvable et proposant des liens vers d'autres contenus.

🎯 Autres facteurs

Plus un site reçoit du trafic et des backlinks, plus il sera rapidement et largement indexé. Googlebot donne la priorité aux textes uniques, mis à jour et optimisés avec des mots-clés. Le HTML et CSS doivent être valides et propres pour faciliter le travail du robot. Par ailleurs, rendez votre site responsive. Avec le mobile-first, l'indexation des smartphones est devenue prioritaire. Tout ce qui améliore l'expérience utilisateur améliore aussi l'indexation par Googlebot.

Comment suivre précisément l'indexation de ses pages web ?

Plusieurs méthodes existent pour surveiller le statut d’indexation de son site. D'abord, vous avez Google Search Console. C'est l'outil de référence fourni par Google pour suivre en détail l'indexation de chaque page.

C'est un outil gratuit fourni par Google qui vous permet de surveiller l'indexation de votre site web. Il fournit des informations sur les pages indexées, les erreurs d'exploration, les statistiques de recherche et bien plus encore. Vous pouvez vérifier l'état d'indexation de vos pages individuelles et soumettre de nouvelles URL pour l'exploration. Faire des recherches sur google en mettant la mention "site:" suivi du lien (site:www.monsite.com) que vous souhaitez savoir s'il est déjà indexer sur google.

Bien que Google Analytics ne suive pas directement l'indexation des pages, il peut vous donner des indications indirectes sur l'activité de recherche organique. Vous pouvez consulter les données de trafic organique pour voir si vos pages sont indexées et génèrent du trafic à partir des moteurs de recherche. Utilisez des outils tels que SEMrush, Ahrefs, Moz ou Serpstat pour surveiller le classement de vos mots clés et l'évolution de votre visibilité dans les résultats de recherche. Si vos pages sont bien classées pour des mots clés pertinents, cela indique qu'elles sont probablement indexées.

Effectuez des recherches manuelles sur les moteurs de recherche en utilisant des mots clés spécifiques pour vérifier si vos pages apparaissent dans les résultats de recherche. Assurez-vous d'utiliser une navigation privée ou une fenêtre de navigation sans connexion pour obtenir des résultats non personnalisés. Surveillez les backlinks (liens provenant d'autres sites web vers le vôtre) en utilisant des outils tels que Majestic, Ahrefs ou SEMrush. Si vos pages sont liées depuis d'autres sites web, cela indique qu'elles sont probablement indexées.

Comment accélérer l'indexation de son site par Google ?

Accélérer l'indexation de votre site par Google est essentiel pour garantir que vos nouvelles pages et mises à jour soient rapidement prises en compte dans les résultats de recherche. Voici quelques stratégies efficaces pour y parvenir.

Soumettre un sitemap XML

Un sitemap XML est un fichier qui liste toutes les pages de votre site, facilitant ainsi le travail des robots d'indexation. En soumettant votre sitemap via Google Search Console, vous permettez à Google de découvrir rapidement vos nouvelles pages et mises à jour. Assurez-vous que votre sitemap est à jour et qu'il contient uniquement les URL que vous souhaitez indexer.

En plus de soumettre votre sitemap, vous pouvez demander à Google d'indexer des pages spécifiques. Utilisez la fonction "Inspection d'URL" pour soumettre manuellement des pages que vous venez de publier ou que vous avez mises à jour. Cela peut aider à accélérer leur indexation.

Créer un contenu de qualité

Le contenu de qualité attire non seulement les visiteurs, mais il incite également les moteurs de recherche à revenir plus souvent sur votre site. Publiez régulièrement du contenu original et pertinent, et assurez-vous qu'il répond aux besoins de votre audience. Plus votre site est actif, plus les robots de Google le visiteront fréquemment.

Optimiser les liens internes

Les liens internes aident à établir une structure claire sur votre site et facilitent la navigation pour les robots d'indexation. En créant des liens vers vos nouvelles pages à partir de contenus existants, vous augmentez leurs chances d'être découvertes et indexées rapidement. Assurez-vous que chaque page importante est bien reliée à d'autres pages pertinentes de votre site.

Promouvoir votre contenu

La promotion de votre contenu sur les réseaux sociaux et d'autres plateformes peut générer du trafic vers votre site, ce qui attire l'attention des robots d'indexation. Partagez vos articles, vidéos ou autres contenus sur des réseaux sociaux, des forums ou des newsletters pour augmenter leur visibilité. Plus votre contenu est partagé, plus il est susceptible d'être indexé rapidement.

Améliorer la vitesse de chargement

Un site rapide favorise une meilleure expérience utilisateur et incite Google à l’indexer plus rapidement. Optimisez vos images, réduisez le poids de vos fichiers et utilisez des techniques de mise en cache pour améliorer les temps de chargement. Un site performant est non seulement apprécié par les utilisateurs, mais aussi par les moteurs de recherche.

Les erreurs d'indexation à éviter sur son site

L'indexation est un processus crucial pour assurer la visibilité de votre site web sur les moteurs de recherche. Cependant, plusieurs erreurs peuvent nuire à cette indexation, entraînant une baisse du trafic et une mauvaise expérience utilisateur. Voici quelques-unes des erreurs les plus courantes à éviter.

1. Mauvaise utilisation des fichiers robots.txt

Le fichier robots.txt est un outil essentiel pour contrôler l'accès des robots d'indexation à certaines parties de votre site. Une erreur fréquente consiste à bloquer des pages importantes par inadvertance. Il est donc crucial de vérifier régulièrement ce fichier pour s'assurer qu'il n'empêche pas l'indexation de contenus que vous souhaitez voir apparaître dans les résultats de recherche.

2. Contenu dupliqué

Le contenu dupliqué peut sérieusement affecter votre classement dans les moteurs de recherche. Lorsque plusieurs pages de votre site affichent le même contenu, les moteurs de recherche peuvent avoir du mal à déterminer laquelle indexer. Pour éviter cela, utilisez des balises canonicals pour indiquer la version préférée d'une page et assurez-vous de créer un contenu unique pour chaque page de votre site.

3. Liens internes mal structurés

Une structure de liens internes bien pensée est essentielle pour l'indexation. Si vos pages ne sont pas correctement liées entre elles, les robots d'indexation peuvent avoir du mal à naviguer sur votre site. Assurez-vous que chaque page importante est accessible via des liens internes, et évitez de créer des pages orphelines qui ne sont reliées à aucune autre page.

4. Pages avec un temps de chargement élevé

La vitesse de chargement des pages est un facteur clé pour l'expérience utilisateur et l'indexation. Les moteurs de recherche privilégient les sites qui se chargent rapidement. Si votre site est lent, cela peut entraîner une mauvaise indexation. Optimisez les images, réduisez les scripts inutiles et envisagez d'utiliser un réseau de distribution de contenu (CDN) pour améliorer les temps de chargement.

5. Ignorer les balises méta

Les balises méta, en particulier la balise title et la balise description, jouent un rôle important dans l'indexation. Elles aident les moteurs de recherche à comprendre le contenu de vos pages. Négliger ces balises peut entraîner une mauvaise indexation et une baisse du taux de clics. Veillez à ce que chaque page ait une balise title unique et descriptive, ainsi qu'une balise description attrayante.

Conclusion

Comprendre le processus d'indexation des sites web par Google est essentiel pour améliorer la visibilité et la présence en ligne d'un site. L'indexation est le mécanisme par lequel Google explore, analyse et enregistre les pages web dans son index, afin de pouvoir les afficher dans les résultats de recherche pertinents. En comprenant comment fonctionne l'indexation, les propriétaires de sites web peuvent prendre des mesures pour optimiser leur site et maximiser leurs chances d'être indexés et classés de manière appropriée.

Cela inclut des pratiques telles que la création de contenu unique et de haute qualité, l'utilisation de balises méta pertinentes, l'évitement du contenu en double, la correction des erreurs d'exploration et la résolution des problèmes techniques. En utilisant des outils tels que Google Search Console, Google Analytics et des outils de suivi des mots clés, il est possible de surveiller l'indexation de son site web, d'identifier les problèmes potentiels et de prendre les mesures nécessaires pour améliorer la visibilité dans les résultats de recherche.

FAQ

Q: Qu'est-ce que l'indexation des sites web chez Google?

R: L'indexation des sites web chez Google est le processus par lequel Google explore, analyse et enregistre les pages web dans son index, afin de pouvoir les afficher dans les résultats de recherche pertinents.

Q: Comment puis-je savoir si mon site web est indexé par Google?

R: Vous pouvez vérifier si votre site web est indexé par Google en effectuant une recherche "site:votresite.com" dans la barre de recherche Google. Cela affichera les pages de votre site qui sont actuellement indexées.

er les problèmes potentiels tels que des problèmes techniques, du contenu en double ou des backlinks de mauvaise qualité. Ensuite, prenez les mesures nécessaires pour résoudre ces problèmes et améliorer l'optimisation de votre site.

Laisser un commentaire